[论文阅读] Transformer(Attention Is All You Need)

单位: Google

会议: NeurIPS 2017

论文地址: arxiv

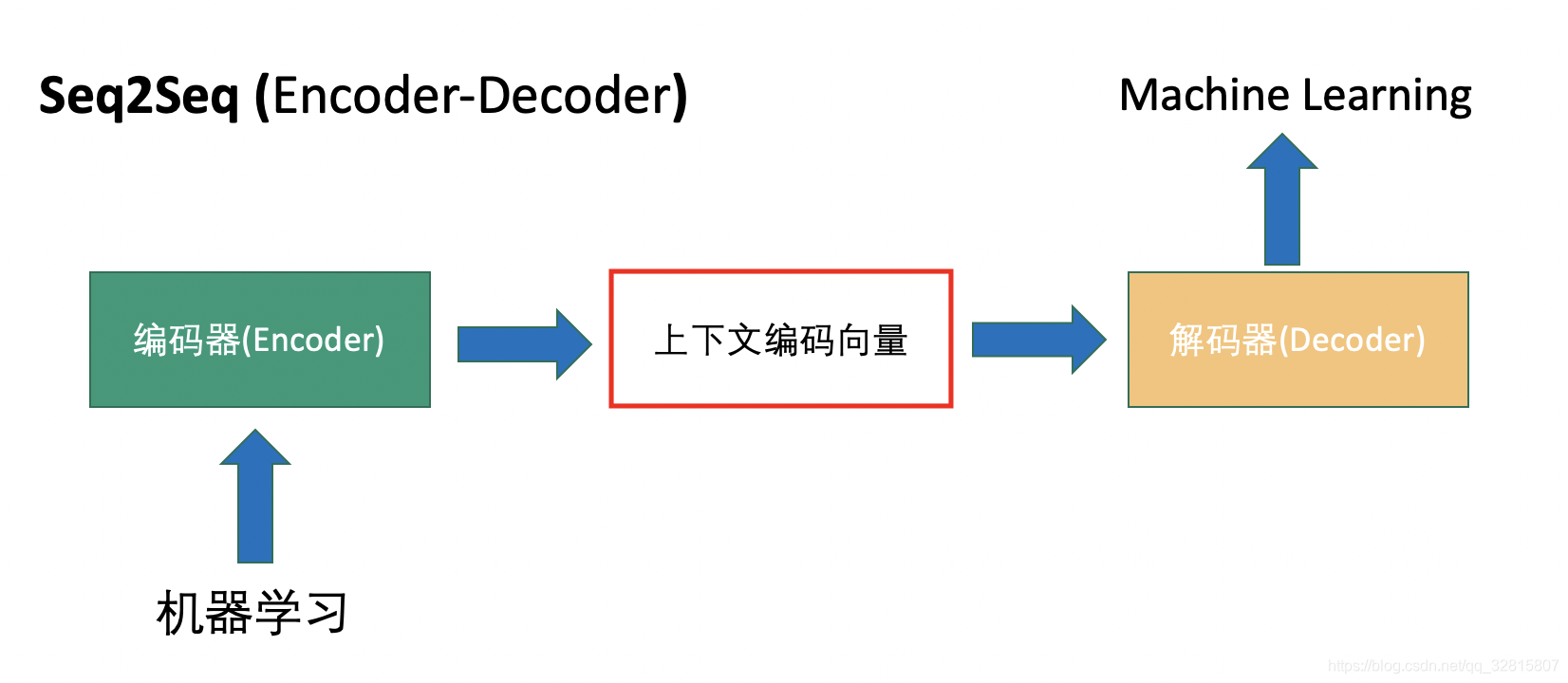

Seq2Seq

Encoder和Decoder在早期一般是RNN模块,后来引入了LSTM或者GRU模块,核心思想都是通过Encoder编码成一个表示向量,即上下文编码向量,然后交给Decoder来进行解码,翻译成目标语言

RNN的局限

对于不同输入和输出长度,中间的上下文编码向量长度固定的,仅仅靠一个固定长度的上下文编码向量包含的信息有限

RNN 本质是一个马尔科夫决策过程无法很好地学习到全局的结构信息

难以并行化,速度慢

CNN

在 FaceBook 的论文(Convolutional Sequence to Sequence Learning)中纯粹使用CNN也完成了 Seq2Seq 的学习

CNN 方便并行,而且容易捕捉到一些全局的结构信息

但CNN 事实上只能获取局部信息,是通过层叠来增大感受野

在Transformer中,完全抛弃了RNN和CNN等网络结构,仅仅采用Attention机制就取得了很好的效果,具有更好的质量,同时具有更高的并行性和更少的训练时间

这篇主要贡献之一是它表明了内部注意力在机器翻译(甚至是一般的 Seq2Seq 任务)的序列编码上是相当重要的,而之前关于 Seq2Seq 的研究基本都只是把注意力机制用在解码端。

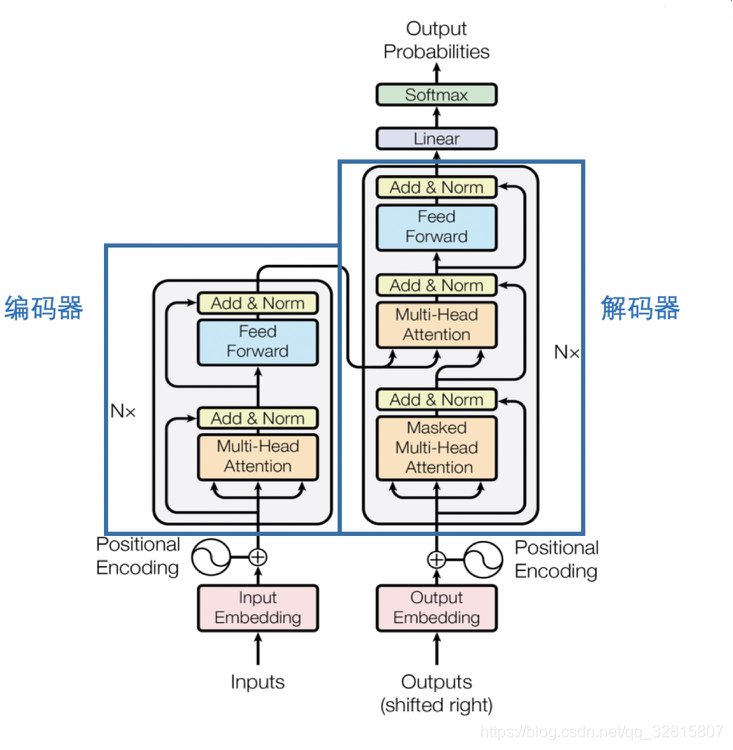

Transformer Architecture

Transformer结构可以表示为Encoder和Decoder两个部分

Encoder和Decoder主要由Self-Attention和Feed-Forward Network两个组件构成

Self-Attention由Scaled Dot-Product Attention和Multi-Head Attention两个组件构成。

Self-Attention

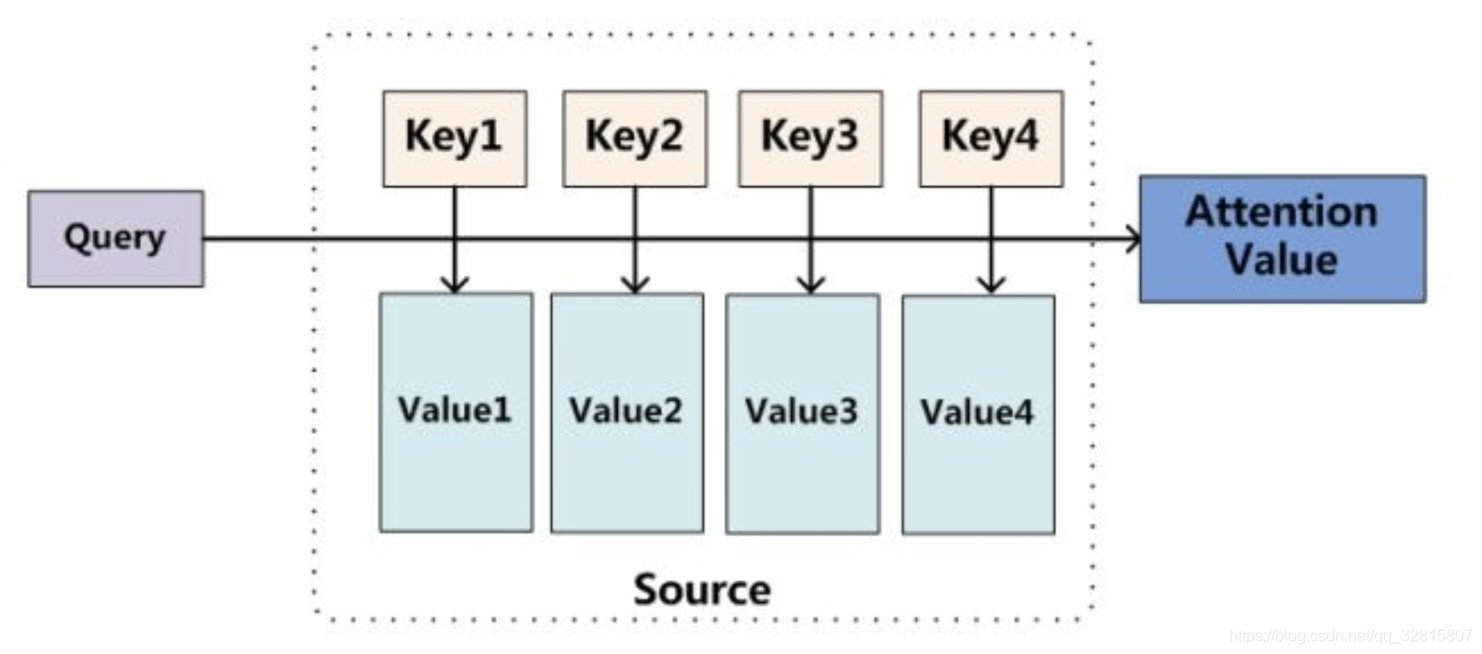

Attention 机制来自于人类视觉注意力机制,人们视觉在感知东西的时候一般不会是一个场景从到头看到尾每次全部都看,而往往是根据需求观察注意特定的一部分

注意力函数的本质可以被描述为一个查询(query)到一系列(键key-value值)对的映射

注意力函数的本质可以被描述为一个查询(query)到一系列(键key-value值)对的映射

给定一个和任务相关的查询查询向量 q,通过计算与Key的注意力分布并附加在Value上,从而计算Attention Value

引入attention的好处

注意力允许解码器以不同程度的权重利用到编码器的所有信息

通过检查注意力分布,可以看到解码器在关注什么,可解释性

Self-Attention的QKV来自同一个输入,也就是说在序列内部做 Attention,寻找序列内部的联系,故称为自注意力层

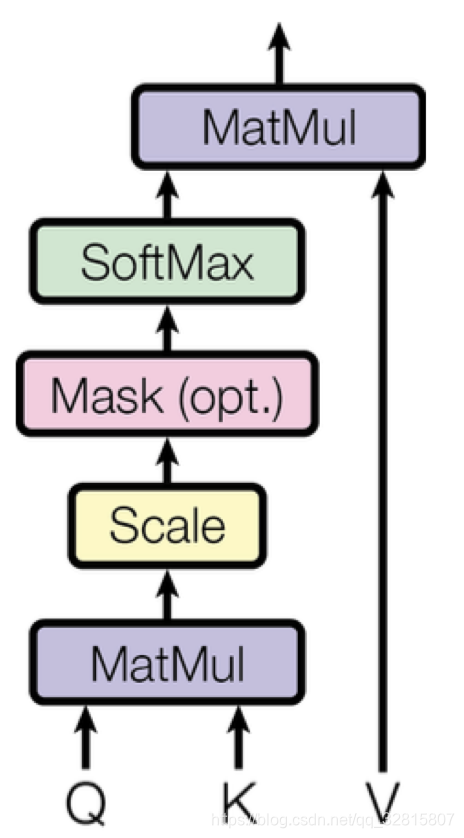

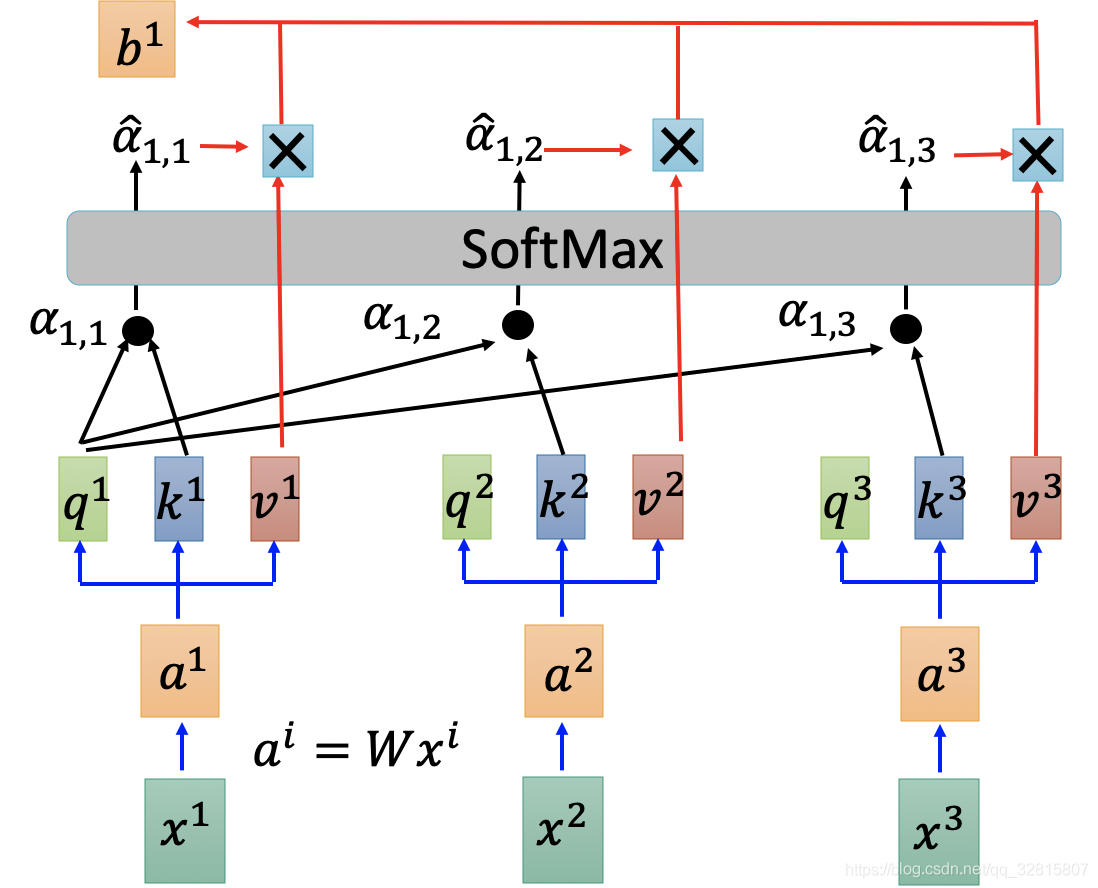

Scaled Dot-Product Attention

计算过程

- 对每个输入单词$x^1,x^2,x^3$转化成嵌入向量

- 根据嵌入向量分别得到$q$,$k$,$v$三个向量

- 然后将$q$和所有$k$进行点乘计算得$\alpha$

- 通过SoftMax转换为概率分布$\hat{\alpha}$

- 将概率分布和所有$v$进行加权求和得到输出$b$

为什么scaled?

可参考transformer中的attention为什么scaled?

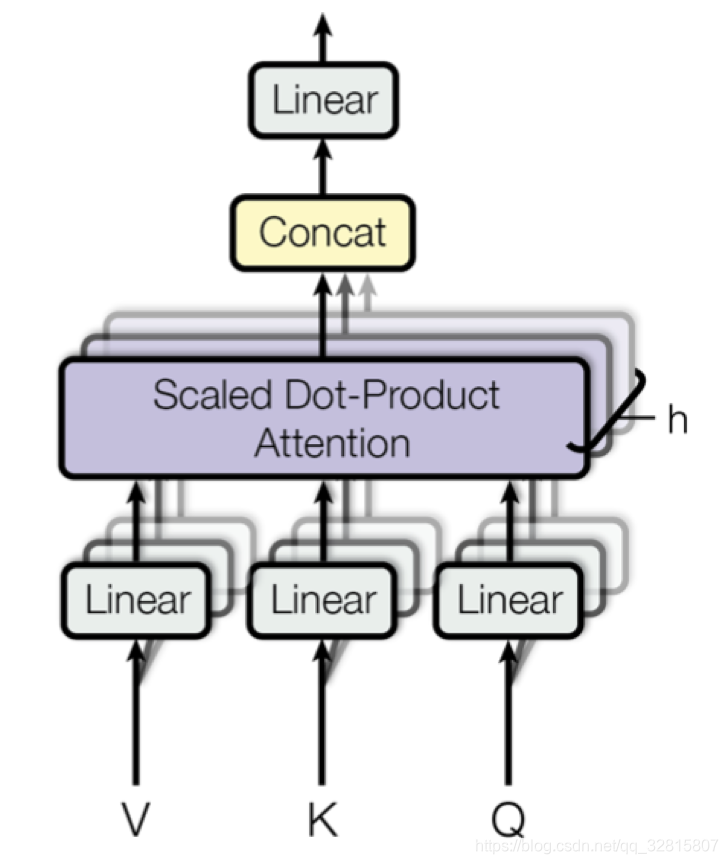

Multi-Head Attention

Multi-Head Attention相当于多个不同Scaled Dot-Product Attention的集成,以8为例子,Multi-Head Attention步骤如下:

将数据$X$分别输入到8个不同的Scaled Dot-Product Attention中,得到8个加权后的特征矩阵$Z_{i}, i \in{1,2, \ldots, 8}$

将8个$Z$按列拼成一个大的特征矩阵

特征矩阵经过一层全连接得到输出$Z$

可以类比CNN中同时使用多个卷积核的作用,多头的注意力有助于网络捕捉到更丰富的信息,每个head关注的点可能不一样,可以处理不同的任务

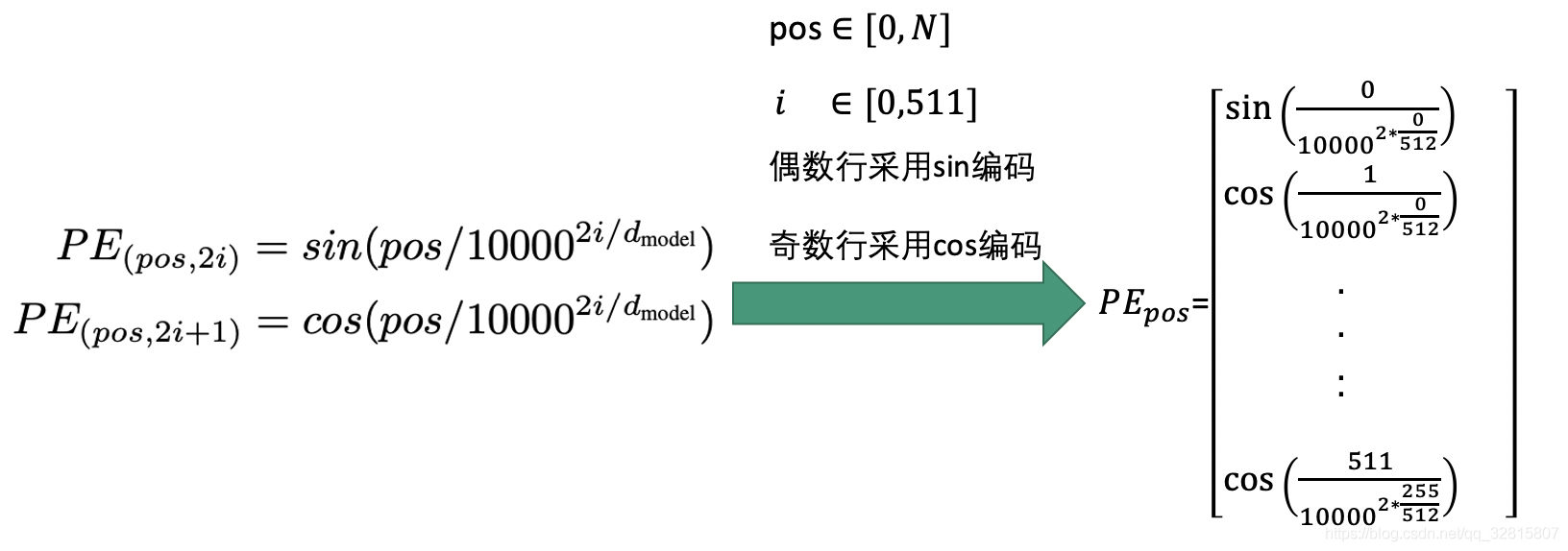

Positional Encoding

transformer内部没有类似RNN的循环结构,没有捕捉顺序序列的能力,无论句子结构怎么打乱,transformer都会得到类似的结果

为了解决这个问题,在编码词向量时会额外引入了位置编码向量

将每个位置编号,然后每个编号对应一个向量,通过结合位置向量和词向量,就给每个词都引入了一定的位置信息,这样 Attention 就可以分辨出不同位置的词了

- 将向量的512维度切分为奇数行和偶数行

- 偶数行采用sin函数编码,奇数行采用cos函数编码

- 然后按照原始行号拼接

由于有

所有的$PE{pos+k}$可以用$PE{pos}$线性表出,表达了相对位置信息

同样的也可以训练得到位置编码向量,但是试验结果表明相差不大,因此论文选择了直接定义,这样直接计算而不需要训练,减少了训练参数,同时允许模型将位置编码向量扩展到超过了训练集中最长序列长度的位置编码

Feed-Forward Networds

在每个子层中,Multi-Head Attention层都接了一个FFN层,先线性变换,然后ReLU非线性,再线性变换

作用将Attention结果映射到一个更大维度的特征空间

在抛弃了 LSTM 结构后,FFN 中的 ReLU成为了一个主要的能提供非线性变换的单元

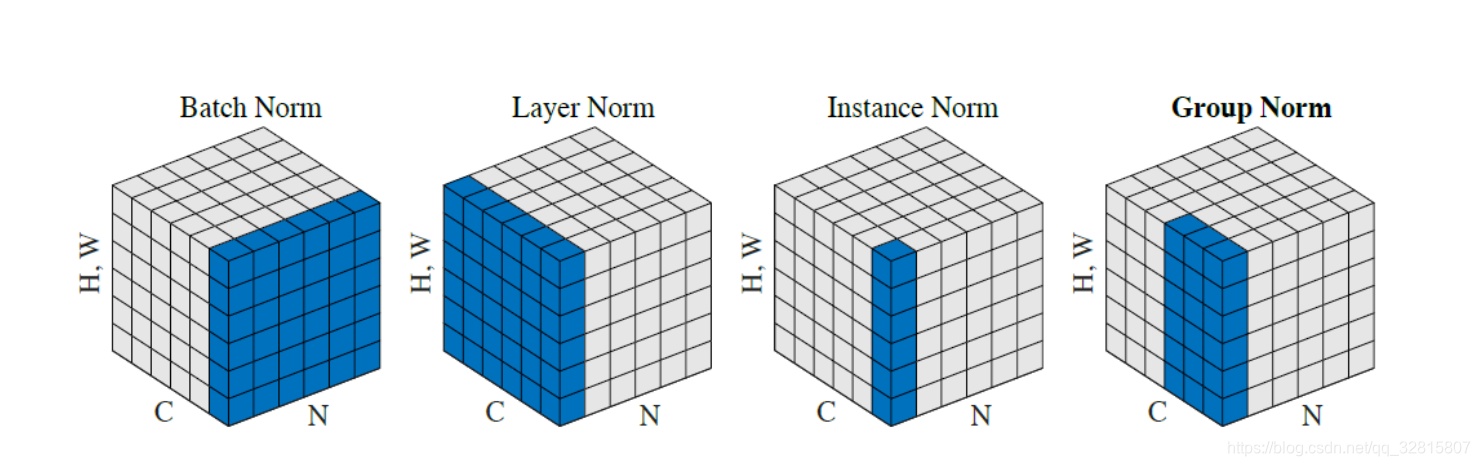

Layer Norm

主要的几种归一化方法

Batch Normalization

Layer Normalization

Instance Normalization

Group Normalization

将输入的图像shape记为[N, C, H, W],这几个方法主要的区别

BatchNorm是在batch上,对NHW做归一化,对小batchsize效果不好

LayerNorm在通道方向上,对CHW归一化,主要对RNN作用明显

InstanceNorm在图像像素上,对HW做归一化,用在风格化迁移

GroupNorm将channel分组,然后再做归一化

Transformer为什么选用Layer Normalization呢?

看了知乎上一些关于使用BN效果不好的讨论

比较同意是因为NLP数据和CV数据特性不同带来的影响,数据的相关性表现在哪个维度,决定了采用何种信息抽取方式

BN是对不同样本的同一特征做操作而LN是对单个样本的不同特征做操作

在NLP中不同batch样本的信息关联性不大,而且由于不同的句子长度不同,强行归一化会损失不同样本间的差异信息,所以就没在batch维度进行归一化,而是选择LN,只考虑的句子内部维度的归一化。